Künstliche Intelligenz verändert gerade, wie wir arbeiten, denken und entscheiden. Viele erleben KI als Werkzeug, andere als Blackbox – schnell, mächtig, aber oft auch komplex und schwer einzuordnen.

Im Magnetprodukt-Club verstehen wir KI als Teil einer gemeinsamen Lern- und Entwicklungsreise. Als etwas, das ganz selbstverständlich in unsere Membership eingebettet ist.

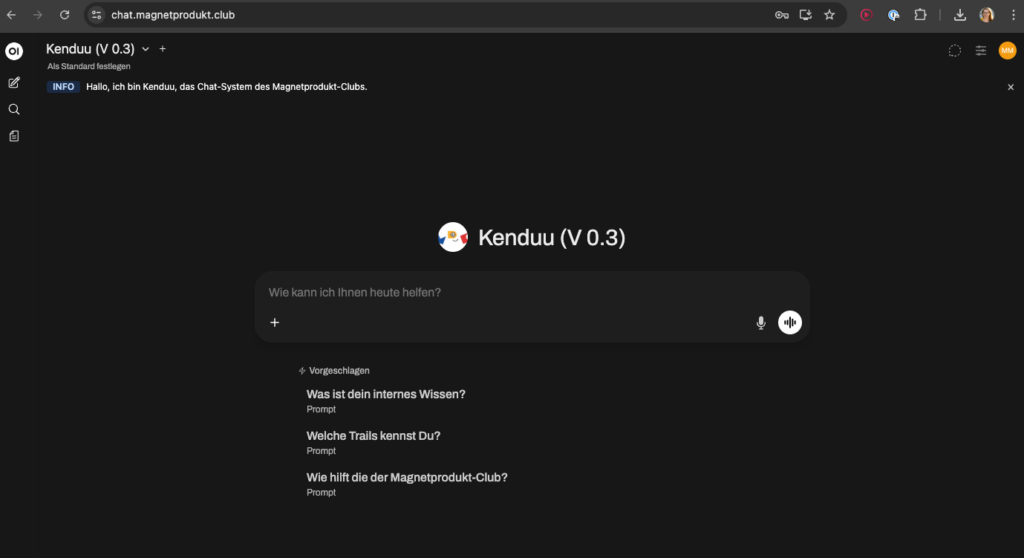

Wir sehen den MPC-Kenduu-Chat als ergänzendes Club-Community-Werkzeug: Gebaut auf eure Fragen, gespeist aus unserem Wissen, entwickelt im Dialog mit euch.

In diesem Artikel geben wir dir einen transparenten Blick hinter die Kulissen: Du erfährst, wie unser »Kenduu-GPT« technisch aufgebaut ist, warum wir uns bewusst für eine eigene Infrastruktur entschieden haben und was du als Alpha-Tester:in erwarten kannst – jenseits von Hype, dafür mit Neugier und Gestaltungsfreude.

Warum heißt der Chat im Magnetprodukt-Club eigentlich Kenduu-Chat?

Es schien uns naheliegend, das KI-Chat-System nach unserem Club-Maskottchen »Kenduu« zu benennen. Kenduu steht für eine »You can do it« Mentalität, ist beharrlich, neugierig, lernbereit, spielfreudig und arbeitet nach der Devise »Done is better than perfcet.« Das scheinen uns ideale Eigenschaften für den Umgang mit KI.

Wo läuft der MPC-Kenduu-Chat?

Die Clubst@rs melden sich bei unserer Open WebUI Instanz an. Open WebUI ist eine Open-Source-Benutzer-Umgebung für KI-Anwendungen, die entwickelt wurde, um die Arbeit mit Large Language Models (LLMs) zu vereinfachen.

Sie ist benutzerfreundlich, flexibel erweiterbar und läuft vollständig auf unserer eigenen Infrastruktur.

Das System unterstützt verschiedene KI-Modelle, unter anderem über OLLAMA sowie über OpenAI-kompatible Schnittstellen. So können wir unterschiedliche KI-Systeme anbinden und je nach Bedarf nutzen.

Open WebUI lässt sich einfach über moderne Servertechnik betreiben und ermöglicht eine sichere Benutzerverwaltung mit klaren Zugriffsrechten. So stellen wir sicher, dass der Chat nur für den Club zugänglich ist und eure Inhalte geschützt bleiben.

Open WebUI ist das Cockpit, über das ihr mit unserer Club-KI arbeitet.

Wo liegt der Server?

Unser Server läuft beim deutschen Hoster Sliplane.io. in Bayreuth. Sie stellen uns für ein überschaubares Budget einen »Container« (ein sog. Docker-Image) bereit, in dem unser Cockpit mit OpenWebUI gehostet ist.

Welche KI-Systeme bzw. Large Language Models (LLMs) nutzt ihr?

Wenn man sich jetzt auf dieser Webseite anmeldet und dort chattet, dann sieht das aus wie zum Beispiel ChatGPT. Aber wir benutzen nicht ChatGPT.

Wir nutzen unterschiedliche Modelle vom unabhängigen Dienstleister OLLAMA mit Daten, die wir aus dem Clubhaus ausgelesen habe – also die Trails und Blogposts von Maren.

Dadurch, dass wir das bei OLLAMA hosten, können wir sicher sein, dass niemand unsere Inhalte benutzt, um damit KI weiter zu trainieren.

OLLAMA nutzt unterschiedliche Quellen:

- Meta hat einige Modelle öffentlich gemacht.

- OpenAI mittlerweile auch.

- Dann gibt es die französische Firma Mistral.

- Und eben auch einige chinesische Modelle.

In unseren Experimenten hat sich gezeigt, dass wir mit den chinesischen Modellen relativ gut arbeiten können, weil sie zum Teil sehr groß sind – also sehr viel können – und gleichzeitig sehr performant sind. Das ist eine attraktive Kombination.

Warum habt ihr euch für dieses technische Setup entschieden?

Da sind unterschiedliche Komponenten dabei.

Fangen wir mal mit der Software OpenWeb UI an:

- Wir wollten etwas haben, das quelloffen ist, d.h. an dem wir zur Not auch selber Hand anlegen kann.

- OpenWebUI ist schon relativ lange auf dem Markt ist und hat eine sehr große User-Community hat. Unsere Erfahrung zeigt, dass auftretende Probleme mit hoher Wahrscheinlichkeit schnell behoben werden.

Bei der Auswahl des Hosters waren drei Aspekte wichtig:

- Sitz in Deutschland wegen Datenschutz.

- Kostengünstig.

- Skalierbar. Sprich: Wenn nach unserem Alpha-Test feststellen, dass wir mehr Ressourcen brauchen (mehr Arbeitsspeicher, mehr Prozessorleistung o.ä.) können wir schnell und unkompliziert einen leistungsfähigeren Container auswählen.

Beim LLM ist uns wichtig:

- Das Modell sollte die Frage verstehen.

- Es sollte sie aus dem Wissen beantworten, das wir im Club zur Verfügung stellen.

- Es sollte vernünftige Antworten und Folgefragen erzeugen.

- Es sollte nicht „ausbüxen“, heißt: nicht irgendetwas erzählen, was es irgendwo in seinem Training gelesen hat, sondern bei dem bleiben, was wir im Club an Informationen haben – in den Trails und Blogartikeln.

- Es muss außerdem verstehen, was es liest.

- Es sollte deutsch sein.

- Es sollte ganze Sätze formulieren.

- Es soll halbwegs schnell antworten.

Wo sind die Grenzen dieses Set-ups?

Wir erreichen mit unserer aktuellen Hardware nicht die Antwortzeiten von ChatGPT, Gemini oder ähnlichen Systemen. Das heißt, unsere Alpha-Tester:innen brauchen etwas mehr Geduld und Fehlertoleranz #Schneckenpower.

Es sollte sie nicht überraschen, wenn

- es hin und wieder nicht funktioniert. Wenn irgendwo eine Fehlermeldung erscheint. Das ist unerfreulich, daran arbeiten wir.

- Antworten etwas länger dauern als bei ChatGPT oder Gemini.

- Links auftauchen, die (noch) auf eine 404-Seite führen.

Frage: Was erhofft ihr euch von den Alpha-Tester:innen?

Die Chance ist auf jeden Fall, dass wir ein Gefühl dafür bekommen, ob unser Ansatz trägt. Ob das den User:innen wirklich hilft. Das hat höchste Priorität.

Wir hoffen zu lernen, wie wir unser Prompting verbessern können, bessere Informationen zur Verfügung stellen und unser Wissen gegebenenfalls überarbeiten, um bessere Antworten zu ermöglichen.

Du hast weitere Fragen? Dann schreib uns gerne an post@magnetprodukt.club.

Rückmeldungen